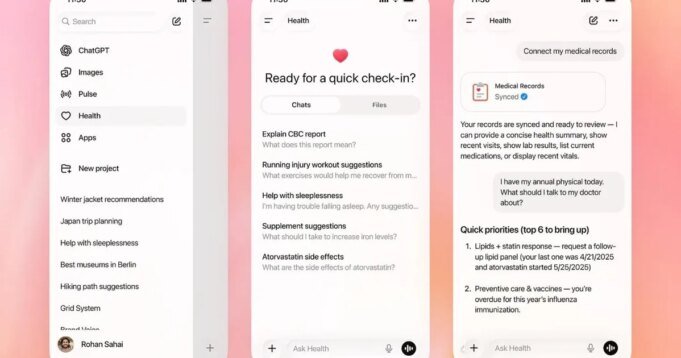

All’inizio di questo mese, OpenAI ha introdotto un nuovo spazio incentrato sulla salute su ChatGPT, pubblicizzandolo come un modo più sicuro per gli utenti di porre domande su argomenti sensibili come dati medici, malattie e fitness. Uno dei punti salienti del lancio è stata la capacità di ChatGPT Health di analizzare i dati di app come Apple Health, MyFitnessPal e Peloton per scoprire tendenze a lungo termine e fornire risultati personalizzati. Ma un nuovo rapporto suggerisce che OpenAI potrebbe aver sovrastimato l’efficacia della funzionalità nel ricavare informazioni affidabili da tali dati.

Secondo i primi test condotti da Washington PostQuando ChatGPT Health ha avuto accesso a un decennio di dati Apple Health, il chatbot ha valutato la salute cardiaca del reporter come una F. Ma dopo aver esaminato la valutazione, un cardiologo l’ha definita “infondata” e ha affermato che il rischio effettivo di malattie cardiache del reporter era estremamente basso.

Dott. dello Scripps Research Institute. Eric Topol ha offerto una valutazione sincera delle capacità di ChatGPT Health, affermando che lo strumento non era preparato a offrire consulenza medica e faceva troppo affidamento su metriche inaffidabili dello smartwatch. La valutazione di ChatGPT si basava in gran parte sulle stime del VO2 massimo e della variabilità della frequenza cardiaca dell’Apple Watch; Entrambi presentano limitazioni note e possono variare in modo significativo tra dispositivi e build di software. Una ricerca indipendente ha scoperto che le stime massime del VO2 di Apple Watch sono spesso basse, ma ChatGPT le considera comunque chiari indicatori di cattiva salute.

ChatGPT Health ha assegnato voti diversi per gli stessi dati

I problemi non finirono qui. Quando il giornalista ha chiesto a ChatGPT Health di ripetere lo stesso esercizio di classificazione, il punteggio ha oscillato tra F e B tra le conversazioni; Il chatbot a volte ignorava gli ultimi risultati degli esami del sangue a cui aveva accesso e talvolta dimenticava dettagli di base come l’età e il sesso del giornalista. Anche Claude for Healthcare di Anthropic è stato lanciato all’inizio di questo mese e ha mostrato una coerenza simile, assegnando voti che vanno da C a B-meno.

Sia OpenAI che Anthropic hanno sottolineato che i loro strumenti non sono destinati a sostituire i medici e hanno solo lo scopo di fornire un contesto generale. Tuttavia, entrambi i chatbot hanno fornito valutazioni sicure e altamente personalizzate della salute cardiovascolare. Questa combinazione di autorità e incoerenza può spaventare gli utenti sani o dare falsa fiducia agli utenti non sani. Anche se l’intelligenza artificiale potrebbe alla fine sbloccare preziose informazioni dai dati sanitari a lungo termine, i primi test mostrano che l’aggiunta di anni di dati di monitoraggio del fitness a questi strumenti attualmente crea più confusione che chiarezza.

Link alla fonte: www.digitaltrends.com